联合熵、条件熵、熵

\[ H(X, Y) = H(X) + H (Y|X)\]

proof:

\[ \begin{aligned} H(X,Y) &= -\sum_{x,y} p(x,y)\,\log p(x,y) \\ &= -\sum_{x,y} p(x,y)\,\log\!\big(p(x)\,p(y\mid x)\big) \\ &= -\sum_{x,y} p(x,y)\,\log p(x) \;-\; \sum_{x,y} p(x,y)\,\log p(y\mid x) \\ &= -\sum_{x} \Big(\sum_y p(x,y)\Big)\log p(x) \;-\; \sum_x p(x)\sum_y p(y\mid x)\,\log p(y\mid x) \\ &= -\sum_x p(x)\log p(x) \;+\; \sum_x p(x)\,\Big(-\sum_y p(y\mid x)\log p(y\mid x)\Big) \\ &= H(X) \;+\; \sum_x p(x)\,H(Y\mid X{=}x) \\ &= H(X)+H(Y\mid X). \end{aligned} \]

记忆信源与无记忆信源

记忆信源:符号出现的概率与之前出现过的符号有关

无记忆信源:符号出现的概率与之前出现过符号的概率无关,只由符号自身的概率决定

tips: 离散信源的输出是一个符号表{x1, x2, x3…}

二重信源

def: 把原信源连续的两个符号当成一个新符号来看的那个新信源

马尔科夫信源

def: 即有记忆的离散信源

k阶马尔科夫信源:当前输出符号与前k个符号有关

状态转移

类似于FSM(有限状态机)。 wiki about FSM

马尔科夫信源熵

从一个状态到另一个状态发生转移并发出一个符号的熵

信源平均输出一个符号的熵(每个状态的熵的均值)

冗余度

def: \[ R = 1 - \frac{H(x)}{H_{max}}\]

这里的 \(\frac{H(x)}{H_{max}}\) 也叫信源效率

该值越大说明符号之间的相关性越强,

时间熵

def:平均每秒传递的信息量 (bit/s)

formular:

\[ H_t = H(X) / E(T) \]

其中\(E(T)\)为发送一个符号的平均时间,\(H(X)\)为信源熵即一个符号带有的信息量

编码

def: 为信源发出的每个符号进行编码

香农编码

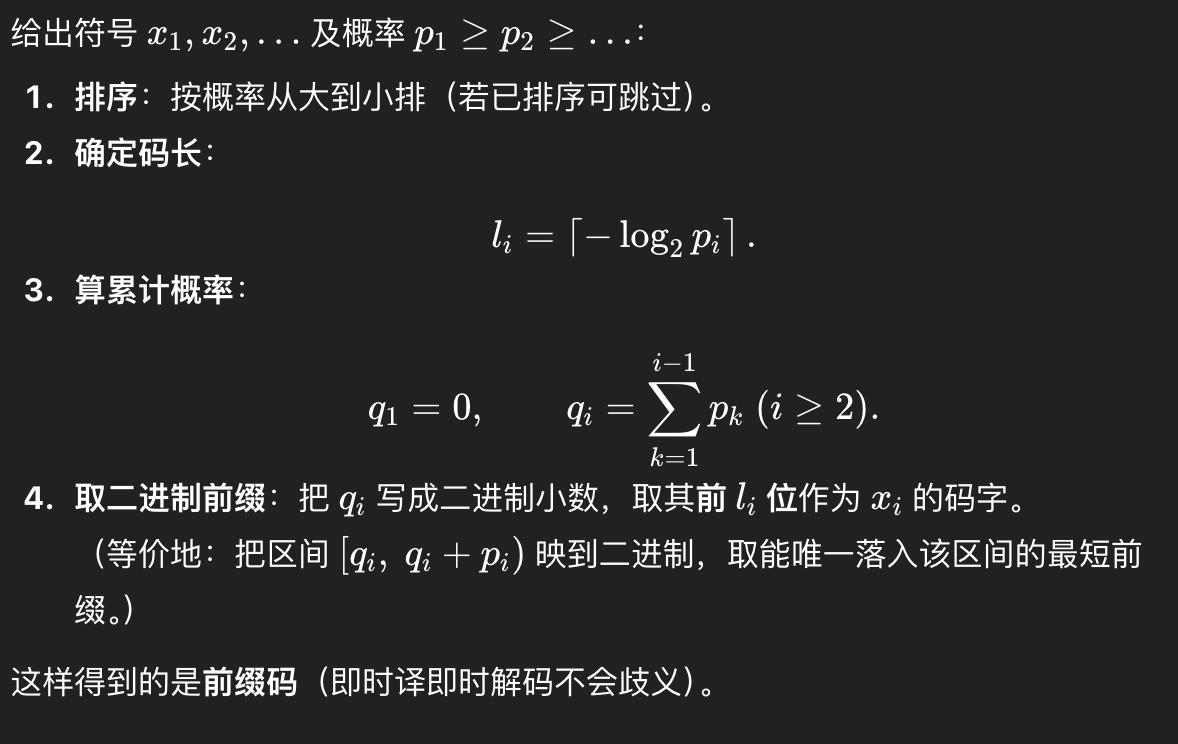

如何进行香农编码:

哈夫曼编码

如何进行哈夫曼编码: wiki about Huffman

编码速率和编码效率

def: 编码速率即平均码长(bit/符号)

\[\bar L = \sum_{i=1}^{\infty} p_i\,l_i\]

def: 编码效率即信源熵/平均码长

\[\eta = \frac{H(X)}{\bar{L}}\]

重要关系

- \(H(X) \leq \bar L\)

即信源熵是平均码长的下界,信源熵是一个信源发出一个符号带来的平均不确定度/信息量(需要多少bit去表示这个符号的发生),而平均码长就是该编码表示一个符号的平均bits,当二者越接近说明这种编码方式的效率越高.

离散信道容量

Reveiw:

互信息(Mutual Information):是一个衡量“知道一个变量能减少另一个变量多少不确定性”的量,或者说二者共享的信息量。

数学定义为:\(I(X;Y) = H(X) - H(X|Y)\)

信道容量

| 目标 | 量 | 意义 |

|---|---|---|

| 想看输出反映输入多少 | \(I(X;Y)\) | 输入输出共享信息量 |

| 想找信道能力上限 | \(\max_{p(x)} I(X;Y)\) | 最优输入分布下的最大共享信息量 |

数学定义:

\[C =\max_{p(x)} I(X;Y)\]

当信道矩阵(转移概率矩阵)对称时有:

\[C = log_{2}M - H(Y|X)\]

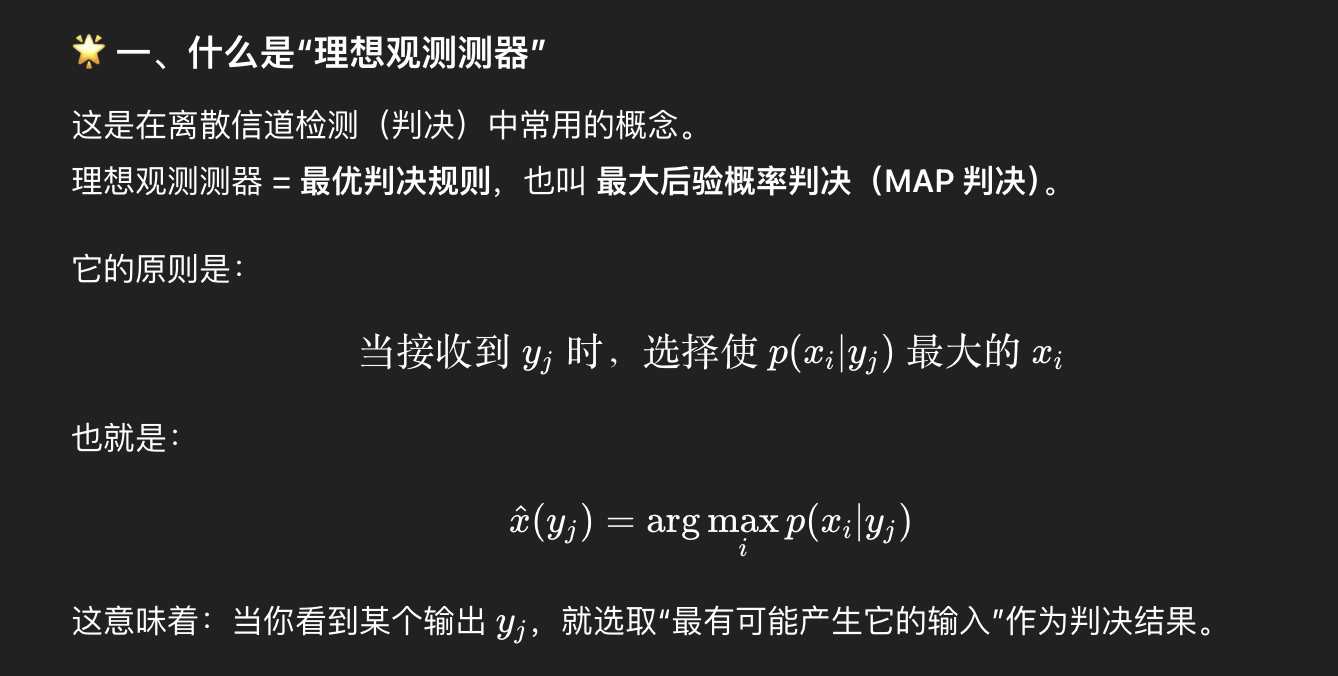

理想观测器

什么是理想观测器(摘自ChatGPT5)

即根据条件概率选择当观测到某个y时,它的输入为x。

误判概率

设计的理想观测器的误判概率

Question

- 几何级数和几何级数求导求和?